Etienne Klein est physicien au Commissariat à l’Énergie Atomique (CEA), et professeur à l’École centrale de Paris. Il a participé à la mise au point du grand collisionneur de particules du CERN, le fameux LHC. Il est l’auteur de nombreux ouvrages de vulgarisation et ses conférences grand public sont très suivies sur le web. Dans son dernier ouvrage, Matière à contredire 1, il fait dialoguer science et philosophie, en nous invitant à « reconstruire la raison ».

Nous l’avons rencontré pour mieux comprendre ces « découvertes négatives » qui ébranlent nos certitudes sur les limites de la connaissance et la nature de la réalité.

Merci à Thibaut Gress pour l’aide à la préparation des questions.

Merci à Bruno Doussau pour ses conseils et la documentation scientifique.

Enfin, merci à Etienne Klein pour sa disponibilité et sa générosité pour l’entretien et les relectures.

« Penser contre son cerveau »

Actu-Philosophia : Comment fait-on des démonstrations en physique ? A partir de l’observation de phénomènes particuliers, comment arrive-t-on à dégager des lois universelles ?

Etienne Klein : Je pense que l’erreur est justement de penser qu’en physique, les lois viennent de l’induction ou de l’observation. Ce qui est fascinant dans la physique moderne depuis Galilée, c’est que des gens arrivent à trouver des lois qui sont encore les lois qu’on utilise aujourd’hui, alors qu’ils n’avaient pas de données, ou quasiment pas ! En 1604, Galilée énonce la bonne loi de la chute des corps : tous les corps tombent à la même vitesse dans le vide – à une époque où l’on doute sérieusement de l’existence du vide. Cela ne vient pas de données dont il disposait, ni d’expériences qu’il aurait faites depuis la tour de Pise…

Cela montre que les lois se révèlent non pas par la contemplation du spectacle des phénomènes, mais par d’autres stratégies qui visent à les contourner astucieusement, parfois à les contester, pour ensuite les expliquer. D’où la phrase de Koyré que je cite dans le livre : « le pari de la physique moderne est qu’on peut expliquer le réel par l’impossible ».

Il y a là une source d’interrogations pour tout le monde, y compris pour les philosophes : les lois physiques contredisent au premier abord la réalité observable des phénomènes qu’elles décrivent ! Les expériences de pensée de Galilée sont une façon détournée d’interroger le réel à partir de lois qu’on croit vraies, ou plutôt qu’on postule vraies. On essaie de les faire jouer dans des situations qu’on peut imaginer mais pas réaliser. Cela permet de faire parler les équations au-delà d’elles-mêmes. Au-delà en tous cas des domaines où ces équations ont été validées. Ensuite, on peut voir « ce qu’elles ont dans le ventre », si leurs conséquences ultimes sont absurdes ou cohérentes.

Einstein écrit les équations de relativité générale, qui est une nouvelle théorie de la gravitation, en 1915, et ce sont celles qu’on utilise encore aujourd’hui. En 1915, que sait-on sur l’univers ? Qu’est-ce qu’on a observé ? Par rapport à aujourd’hui, presque rien ! On ne sait pas pourquoi les étoiles brillent, parce qu’on ne connaît pas les forces nucléaires, donc on ne comprend même pas qu’un objet comme une étoile puisse émettre de la lumière. A l’époque, on ne sait pas qu’il existe d’autres galaxies que la nôtre. En guise d’objets célestes, on ne connaît que les planètes, les étoiles, les comètes, les météores, c’est tout. Et on ne sait évidemment pas que l’univers est en expansion.

Grâce à ces équations, on a pu prédire les ondes gravitationnelles qu’on a détectées un siècle après, en 2016. On dispose désormais de toutes les données récoltées par les satellites et les télescopes : aucune n’a invalidé les équations d’Einstein !

Une théorie qui résiste à ce point à l’épreuve du temps et des données, je ne dirais pas qu’elle décrit le réel, je ne dirais pas non plus qu’elle est « vraie », mais qu’elle a touché quelque chose qui a à voir avec le réel. Sans quoi on ne comprend pas son efficacité ni sa capacité de résistance par rapport aux nouvelles données.

Maintenant, faites l’expérience de pensée inverse : imaginez que nous ayons toutes les données d’aujourd’hui, recueillies par tous les instruments d’observation du 20ème siècle et du 21ème commençant, mais pas les équations d’Einstein. Pourrait-on déduire les équations des données ? J’en doute fort. Je ne dis pas non de façon absolue : un jour, peut-être, l’intelligence artificielle rendra possibles des logiciels suffisamment intelligents pour découvrir des invariants dans les données. Mais pour le moment, cela semble hors de portée.

Autrement dit, l’induction n’est pas la bonne méthode. Einstein le disait lui-même. Puisque les lois contredisent les phénomènes ! Les lois permettent de critiquer l’observation, de la réinterpréter, comme par exemple le fait que si on voit des corps de masses différentes tomber à des vitesses différentes, ce n’est pas à cause de la gravité, mais parce que d’autres forces que la gravité agissent : résistance de l’air, poussée d’Archimède…

C’est ce que veut dire Bachelard lorsqu’il explique que faire de la science, c’est « penser contre son cerveau ». Obliger le cerveau à remettre en cause ce qui lui paraît évident parce que conforme au réel empirique ou à l’intuition. Mais peut-être que cela changera : avec tout tout le big data qui arrive, on n’aura peut-être plus besoin du geste galiléen consistant à faire des hypothèses, à voir leurs implications et ensuite à concevoir des expériences spécifiques pour voir si ces hypothèses sont juste ou pas.

En tous les cas, la physique n’est pas une « bureaucratie des apparences ». Ses démonstrations ne procèdent pas d’une adéquation directe au réel.. C’est la formulation de lois desquelles on déduit des prédictions, desquelles on déduit des protocoles expérimentaux particuliers, qui ne sont pas l’observation.

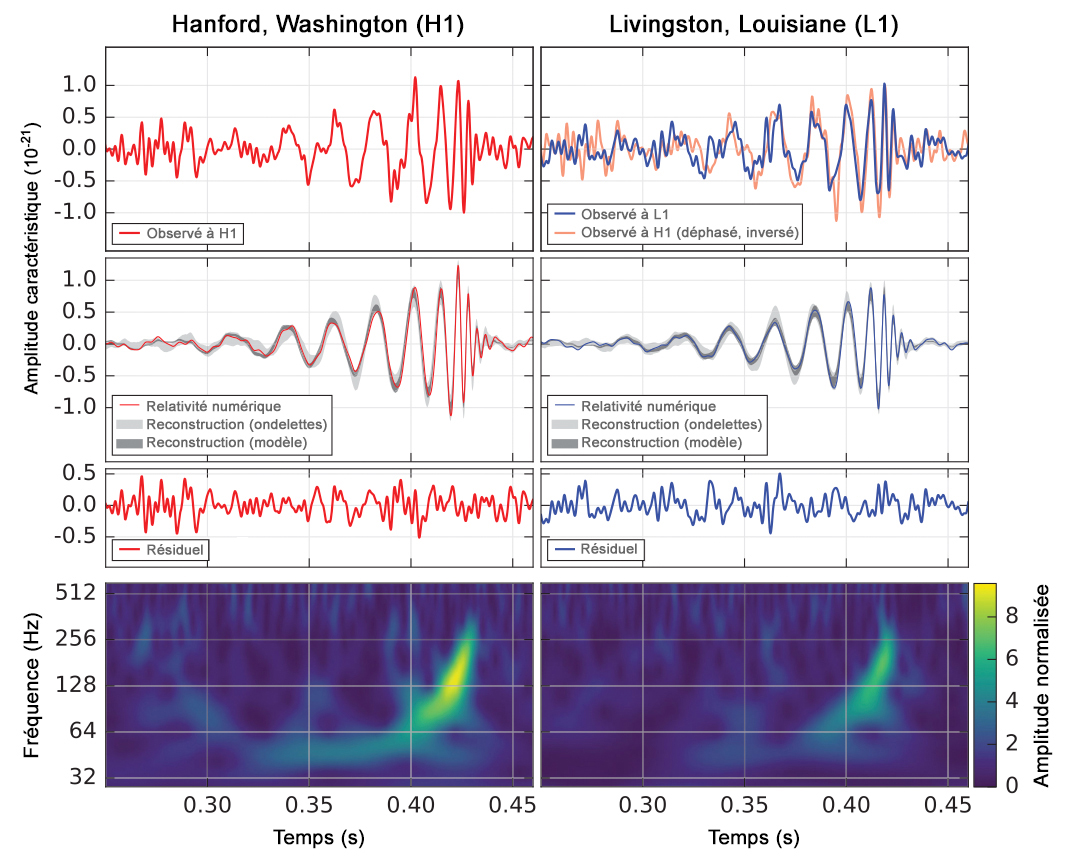

Si on était un peu sensible à la connaissance, quand on a annoncé en 2016 la détection des ondes gravitationnelles, on aurait dû être complètement sidéré. Les ondes détectées sont exactement comme on les avait préalablement calculées. En regardant le spectre du signal, sur une durée d’à peine dix millisecondes, on est capable de déterminer le phénomène physique qui les a engendrées : ce sont deux trous noirs, de 29 et 36 masses solaires [Soit respectivement 29 et 36 fois la masse de notre soleil. Cf. « [Observation of Gravitational Waves from a Binary Black Hole Merger », Physical Review Letter, 11 février 2016.[/efn_note], qui après avoir tourné l’un autour de l’autre, ont fusionné, il y a 1,3 milliard d’années… C’est tout de même incroyable, non, qu’on ait une telle capacité à décrire les phénomènes qu’on détecte ?

AP : Les résultats ont été douteux pendant longtemps.

EK : Oui, car ce sont des expériences qui réclament une très grande sensibilité et qui sont parasitées par toutes sortes de bruits, comme les voitures qui passent dans leur voisinage. Il a fallu mettre au point des techniques spectaculaires de réduction du bruit. De plus, des collègues ont envoyé des leurres, des pièges si vous préférez, pour voir si les autres chercheurs sont capables de les détecter et de constater que ce ne sont pas des ondes gravitationnelles. Ils ne les avertissent qu’au moment où ils vont publier leurs résultats : c’était un fake !

Si vous dites que les lois physiques sont des constructions sociales, il faut expliquer cela. Ce que j’appelle le relativisme sociologique absolu vous invite à considérer que ce sont des coïncidences, une sorte d’invention du réel par les physiciens. Mais si les lois ne sont pas justes et que pourtant elles rendent compte de ce qui se passe, c’est qu’il se produit à chaque fois un miracle. A la fin, cela fait tout de même beaucoup de miracles !

C’est pourquoi je crois qu’il faut prendre les acquis de la physique au sérieux.

Spectre de la première onde gravitationnelle, 14 septembre 2015.

– En haut l’amplitude observée, dans deux détecteurs jumeaux, séparés de 3000 km.

– Au milieu, la simulation des modèles fondés sur la relativité générale. Le résiduel est la différence entre l’observé et le modélisé.

– En bas, le signal analysé en temps-fréquence. Visuellement, le signal est de plus en plus fort (jaune plus intense) et de plus en plus aigu (la courbe grimpe vers les fréquences plus hautes), sur un dixième de seconde, comme un pépiement d’oiseau, d’où le nom de chirp. (Bruno Doussau)

Y a-t-il d’autres univers ?

AP : A quelle échelle commence la physique quantique ? Aux particules ?

EK : Déjà dans l’atome. On ne peut pas comprendre comment un atome émet de la lumière ni en capture sans la physique quantique. D’où vient cette connaissance ? Einstein pensait que le principe créateur résidait dans l’intellect et les mathématiques. Il y a aussi l’expérience, qui peut montrer que certaines idées sont fausses.

Mais c’est un fait incroyable : il n’y a jamais eu autant de découvertes physiques qu’au vingtième siècle, mais il n’y a pas vraiment eu d’autres révolutions que les trois qui se sont produites dans son premier tiers : la relativité restreinte (1905), la relativité générale (1915), la physique quantique (années 1920). Voilà pratiquement un siècle qu’il n’y a pas eu de changement complet de cadre conceptuel. Il y a eu des aménagements, bien sûr. La vision de la matière aujourd’hui n’est plus celle d’il y a un siècle : on connaît les quarks, les leptons, les interactions fondamentales… Mais le cadre conceptuel par lequel on décrit le monde a été fixé dans les années 20. Or, entre 1920 et aujourd’hui, on a gagné dix ordres de grandeur sur la taille des objets observés. A l’époque, les scientifiques regardaient l’atome (environ un dixième de nanomètre), aujourd’hui on en est aux quarks et au boson de Higgs. En 1920, on connaissait l’atome, le noyau, mais pas les forces nucléaires ; la radioactivité était observée mais guère comprise. On avait un modèle planétaire de l’atome qui n’était pas vraiment cohérent. En guise de particules, on connaissait le proton, l’électron, le photon, pas encore le neutron (découvert en 1932). Et pourtant, Schrödinger, Heisenberg et Dirac parviennent à écrire les équations de la physique quantique.

AP : Si la théorie des cordes était validée, cela pourrait être une révolution.

EK : Oui, c’est une révolution potentielle, mais cette théorie rencontre des problèmes. On n’arrive pas à la tester, et dans les domaines où les expériences sont possibles, elle ne se différencie pas des théories qu’elle est censée remplacer ou prolonger. Elle a donc le statut d’une conjecture.

Quand on la couple avec l’inflation cosmique 2, elle se déploie en un nombre gigantesque de formulations différentes : 10^500 3. C’est assez leibnizien ! Ce n’est plus la théorie de l’univers, mais celle de tous les univers possibles qui pourraient être régis par cette théorie ! D’où la théorie des multivers. Vous êtes alors devant une théorie presque métaphysique : soit il n’y a qu’un univers, mais il faut expliquer pourquoi notre univers est tel que ses constantes fondamentales sont ajustées de telle façon que la vie y est possible. Ou bien il y a 10^500 univers et nous sommes dans un univers où la vie est possible, tandis que dans les autres, il n’y a pas les bonnes constantes. Il faudrait confronter cette théorie à des données expérimentales qu’on n’a pas encore, pour la discriminer par rapport aux théories concurrentes.

AP : Un grand nombre de théories des cordes meurent chaque jour. Dès qu’on fait des découvertes, on abandonne certaines théories.

EK : Oui. Au LHC du CERN, on a des logiciels intelligents qui ont intégré tous les modèles qui vont « au-delà du modèle standard », celui qui a fait ses preuves jusqu’à maintenant : on a détecté la dernière particule prédite par lui et qui manquait encore au tableau de chasse, le boson de Higgs. Ensuite, on a des modèles théoriques qui essaient de le dépasser pour décrire ce qui se passe à des énergies encore plus hautes. Il y a par exemple la supersymétrie, mais on n’a pas encore détecté les particules qu’elle prévoit. D’où la question : ces particules existent-elles ?

En réalité, en l’absence de données, c’est très dur de tuer une théorie ou de la confirmer. On a du mal à faire le ménage entre les différents scénarios, sans parler des problèmes de matière et d’énergie noire…

Comment fait-on des découvertes scientifiques ?

AP : Comment progresse la science ? On a vu que ce n’était pas de façon inductiviste. Il semble aussi que le modèle popperien, le falsificationnisme, a des limites. Un Feyerabend va même jusqu’à dire qu’il n’y a pas de méthode, c’est « l’anarchisme méthodologique ». Est-ce que vous penchez pour une épistémologie, qui serait celle de Kuhn ou de Koyré ?

EK : Je suis plutôt du côté de Koyré. Il est très rare que se produise ce que Popper appelle une « expérience cruciale » qui permette de tuer une théorie. Par exemple, quand on a découvert le rayonnement cosmologique en 1964, les défenseurs de l’univers stationnaire (les opposants au modèle du Big bang) avançaient eux aussi des arguments permettant de rendre compte de ce rayonnement. En revanche, il y a des expériences qui tranchent des questions de manière spectaculaire. Par exemple, la découverte du boson de Higgs en 2012, après 48 ans de recherches : cette particule correspond à ce que prédisait le modèle standard. Et les autres modèles prédisaient autre chose, que l’on n’a pas vu. Cette découverte ne ferme pas la discussion mais apporte un élément incontestable (peut-être y a-t-il d’autres bosons de Higgs par exemple). Voilà un cas-limite qui rejoint la théorie de Popper.

Mais dans bien des cas, une expérience ne suffit pas à résoudre une question. En 1905, quand Einstein écrit que l’éther luminifère, notion inventée au 19ème siècle, n’existe pas, on met longtemps à le croire. Par contre, le vide quantique contient des particules virtuelles, qui sont de la matière à l’état léthargique. Donc ce vide n’est pas vide. On peut dire que c’est un éther, si on veut. Mais ce n’est pas l’éther d’Aristote, ni l’éther qu’on respire, ni l’éther luminifère.

Quand on lit sous la plume d’Aristote le mot « éther », je me demande si, inconsciemment, on ne lui attribue pas des pensées qui sont les nôtres plutôt que les siennes. Prenons un autre exemple : lorsque nous lisons les mots « atome » ou « vide » sous la plume de Démocrite ou d’un autre Atomiste de l’Antiquité, commentés par exemple par Jean Salem, qui vient de nous quitter, sommes-nous vraiment capables de comprendre ce qu’ils avaient dans la tête lorsqu’ils utilisaient ces mots, il y a plus de 25 siècles ? Le mouvement de notre pensée ne rétroprojette-t-il pas dans leur signification tout ce que nous avons appris depuis sur les atomes ou le vide, qui ne sont pas du tout comme ils les pensaient ?

Comme je le dis dans le livre, l’atome de la physique, tel qu’on le connaît aujourd’hui, est un objet qui contredit l’idée philosophique d’atome, en tous points.

AP : Parce que cet atome n’est pas insécable.

EK : A commencer par cela, oui, l’atome qui existe en violant son étymologie. Mais pour le reste aussi : il n’est pas plein, il n’est pas compact, il n’est pas éternel, il n’a pas une trajectoire bien définie dans l’espace…

AP : De même, le vide n’est pas vide, ce n’est pas le néant métaphysique.

EK : Et ce n’est même pas l’espace vide, puisque dans sa version quantique, le vide contient la possibilité d’existence des particules…

Quand Popper dit qu’on ne peut jamais prouver une théorie au motif qu’on n’est jamais à l’abri de découvrir un phénomène qui viendrait la contredire la théorie, on a raison. Mais il faut aussi interroger la solidité de théories qui résistent, au cours du temps, à toutes sortes de données qui sont venues les provoquer.

Et contrairement à ce que pense Kuhn, les scientifiques ne sont pas tous conservateurs. Ce n’est pas parce qu’on aime le paradigme qu’on l’entretient, c’est même le contraire ! Au CERN, par exemple, nombreux sont ceux qui attendent avec impatience des résultats qui viendraient illustrer les failles ou les limites du modèle standard de la physique des particules ! Quand en 2015, on a eu un signal un peu bizarre, les chercheurs sont devenus surexcités : en l’espace de six mois, plusieurs centaines d’articles sont parus à propos d’une mystérieuse « particule X »… Mais durant l’été 2015, en accumulant les données, on a compris que ce signal était un simple bruit de fond. L’espoir d’une révolution imminente s’est effondré.

AP : Quand Popper dit qu’une observation permet de falsifier une théorie, il faut que cette observation elle-même soit fiable, et Popper admet que l’observation dépend d’une convention entre scientifiques. Il parle de la « base marécageuse de la science ».

EK : J’admire Popper, j’ai presque tous ses livres, mais je ne suis pas sûr qu’il connaisse bien toute l’histoire de la physique. Il est arrivé que l’erreur ne soit ni dans la théorie, ni dans l’observation, mais dans son interprétation. Quand vous avez une contradiction entre une mesure et une loi en laquelle vous avez confiance, comme la mécanique classique de Newton, si vous êtes popperien, alors vous abandonnez la théorie ou vous la modifiez. Or, la solution à un tel désaccord peut être ontologique plutôt que législative. Cela consiste à faire l’hypothèse qu’existent des éléments de réalité qu’on n’a pas encore identifiés, mais qui, s’ils existent bel et bien, rétablissent l’accord entre la théorie et les observations.

Vers 1840, les scientifiques observent la trajectoire d’Uranus, la planète la plus lointaine du soleil connue à l’époque. Cette trajectoire est une belle ellipse, en accord avec les calculs effectués grâce à la théorie newtonienne de la gravitation, sauf qu’on observe tout de même un petit écart. Si on a confiance en Newton, on ne commence pas par dire qu’il a tort. La plupart des scientifiques considère qu’il a raison, donc qu’il doit exister une planète qu’on n’a pas observée, dont l’effet gravitationnel sur Uranus explique le décalage. En Angleterre, un certain Adams a alors calculé la masse et la trajectoire de cette planète. En France, Arago et Le Verrier l’ont fait à l’observatoire de Paris et ont envoyé leurs résultats à l’académie, qui n’a pas été convaincue. Ils ont alors envoyé leurs calculs à un astronome allemand, Galle. Le soir-même, Galle a pointé son télescope à la position indiquée : il a vu un point lumineux et a attendu que la nuit passe, pour s’assurer que c’était bien une planète et pas une étoile. Et cette planète a été appelée Neptune. Popper aurait dit qu’Uranus n’ayant pas la trajectoire prévue par Newton, la théorie de Newton devait être fausse.

Un peu plus tard, vers 1860, on regarde Mercure, la planète la plus proche du soleil, et on constate là encore un petit désaccord avec la prédiction faite grâce à la théorie de Newton. L’écart constaté est de 43 secondes d’arc par siècle pour le déplacement du périhélie, le point de la trajectoire qui est le plus proche du soleil. C’est l’épaisseur d’un cheveu vu depuis un mètre de distance. Certains se disent que c’est négligeable, que c’est zéro. D’autres disent : non, c’est 43 secondes d’arc par siècle, ce n’est pas zéro. Donc adoptons encore une fois la solution ontologique, et postulons qu’il y a une planète invisible qui explique le décalage.

On est tellement sûr que cette solution est la bonne que la planète en question est baptisée « Vulcain » avant même d’être découverte. Mais personne ne parvient à l’observer.

Arrive alors un jeune homme qui dit : non, ce décalage est la preuve que les équations de Newton sont fausses, et que l’existence de Vulcain n’est pas nécessaire. Il s’appelle Albert Einstein.

Dans des cas similaires, on peut avoir soit une solution ontologique, soit une solution législative. Comment le savoir à l’avance ? Impossible.

Le problème est le même avec la matière noire. On a les équations d’Einstein, on regarde les galaxies, qui bougent sur elles-mêmes et les unes par rapport aux autres, et on voit que leur mouvement est régi par les équations d’Einstein… à condition de supposer qu’il y a dans les galaxies dix fois plus de matière que celle qu’on observe ! On postule donc l’existence d’une matière noire (solution ontologique), car on a confiance dans les équations d’Einstein. Mais de quoi est faite cette matière noire ? On ne parvient pas à le savoir. Peut-être n’existe-t-elle pas ? Cela impliquerait qu’il faut revoir les équations d’Einstein (solution législative).

Il n’y a pas d’expérience cruciale au sens de Popper : au départ, on ne sait pas si c’est la théorie qui doit être incriminée ou si ce sont des données qui nous manquent.

Dans le livre, je cite un exemple merveilleux, qui aurait fait réfléchir Popper : le boson de Higgs. Vous avez une théorie qui « marche », pour le coup, mais quand vous regardez ses équations, elles impliquent que la masse des particules élémentaires est nulle, ce qui n’est pas ce qu’on observe. Si vous êtes popperien, vous dites que la théorie est fausse. Ou bien vous dites comme certains physiciens, qu’on a mal compris depuis Newton ce qu’est la masse. Pour résoudre ce problème, il fallait imaginer qu’il y a un champ présent partout dans le vide et que la masse des particules provient de leur interaction avec ce champ. Nouvelle force, nouvelle loi. C’est une solution à la fois ontologique et législative. C’est l’une des plus belles histoire de la physique !

Dans les cours de philosophie que j’ai vus à Paris-VII, on vous présente Bachelard, Feyerabend, Popper, Kuhn… Mais ce n’est pas simple, même si on peut trouver des solutions chez les uns et les autres qui font écho à des situations particulières.

Je retiens de Popper que l’objectivité de la science ne vient pas de l’objectivité des scientifiques, comme si ceux-ci étaient des gens « purifiés ». Les scientifiques sont aussi subjectifs que n’importe qui. Certains défendent la solution matière noire, d’autres sont contre, mais c’est l’expérience, et non l’objectivité personnelle de tel ou tel, qui permettra de trancher, grâce à un processus d’objectivation collective.

La physique décrit-elle le réel ?

AP : La plupart des gens croient que le physicien observe directement des particules. Or ce n’est pas la norme : on a plutôt des traces de la désintégration des particules. On suppose donc qu’il y a une particule que le modèle a prévue. Qu’est-ce qu’observer en physique contemporaine ? Qu’observe-t-on ?

EK : On parle de détection plutôt que d’observation. En juin dernier, sujet de bac pour les terminales L : « Suffit-il d’observer pour connaître ? » La réponse est évidement négative. Pour s’en convaincre, il suffit de rappeler les expériences de pensée que nous avons déjà évoquées, celles de Galilée ou d’Einstein.

De plus, on n’observe jamais « directement » les particules. Il y a toutes sortes de médiations entre les faits bruts, leur analyse et la théorie qui permet de les interpréter.

On a pu détecter le boson de Higgs parce qu’on l’a reconnu. Comment a-t-on pu le reconnaître ? Parce qu’on le connaissait. Il avait été prédit et caractérisé. On ignorait en revanche sa masse. Or, la façon dont il se désintègre dépend de sa masse. Le modèle standard imposait son existence, mais pas sa masse. Il fallait donc la mesurer. C’était donc un énorme travail de regarder toutes les énergies et de voir s’il n’y avait pas un signal qui lui correspondait.

On a annoncé la découverte du boson le 4 juillet 2012. Mais jusqu’au mois d’avril, on ne voyait rien et on commençait à se demander s’il existait vraiment. Le CERN avait réuni un groupe de travail pour définir les éléments de langages qu’il faudrait utiliser pour le cas où il serait démontré que le boson n’existe pas, ce qui aurait été une découverte beaucoup plus importante que la confirmation de son existence…

AP : Pourquoi ?

EK : Parce que cela aurait « falsifié » le modèle standard, au sens que Karl Popper donnait à ce mot. Du coup, on aurait mal compris d’où vient qu’il ait pu si bien marcher jusqu’alors… !

AP : Que veut dire « exister » pour une particule ?

EK : Produire des phénomènes dont cette particule est la cause. Quand je dis que le boson de Higgs existe, ce n’est pas qu’il est en train de se promener autour de nous. D’ailleurs, il n’en existe plus. Par contre, on peut les recréer en déposant de l’énergie dans le vide quantique. Les bosons de Higgs qui sont là à l’état virtuel deviennent réels et se désintègrent, et c’est comme cela qu’on les perçoit : par les effets produits par leur disparition.

AP : Puisque les choses ont une masse si elles sont en interaction avec le boson, comment les choses peuvent-elles avoir une masse si le boson n’existe plus ?

EK : Ce n’est pas avec le boson mais avec le champ associé. Le champ du boson est présent partout dans le vide quantique, c’est le couplage avec ce champ qui donne aux particules leur masse. Le boson, c’est un quantum associé au champ, et pour le rendre manifeste, il faut donner de l’énergie au champ. C’est ce qu’on fait lors des collisions de particules produites par le LHC. Nous l’avons dit, le vide quantique n’est pas l’espace vide. Il est rempli de ce qu’on pourrait appeler de la matière « fatiguée », constituée de particules bel et bien présentes mais n’existant pas réellement. Ce sont des sortes de fantômes qui ne possèdent pas assez d’énergie pour pouvoir vraiment se matérialiser et qui, de ce fait, ne sont pas directement observables.

Ces particules dites « virtuelles » s’ébrouent de façon végétative, un peu comme des Belles au bois dormant ! Si on veut qu’elles existent vraiment, il faut leur donner une sorte de baiser énergétique, en l’occurrence les mégaélectronvolts qui manquent à leur pleine incarnation. Pour ce faire, il suffit de faire entrer en collision, au-dessus de leur tête, deux particules de haute énergie, qui, tels des princes charmants microscopiques, offrent leur énergie au vide. Du coup, certaines particules virtuelles deviennent réelles et s’échappent hors de leur repaire. Elles qui faisaient une petite sieste depuis les débuts de l’univers retrouvent leur vitalité d’antan et s’extraient du vide quantique avec une énergie qui peut être très grande. C’est ce qui est arrivé aux bosons de Higgs qui ont été détectés.

AP : Vous distinguez souvent ce qui est vrai de ce qui marche. Un modèle peut expliquer l’élaboration de certaines technologies sans que le modèle soit absolument vrai, c’est-à-dire fidèle à la réalité. On a l’impression qu’un écart se creuse entre la vérité et l’efficacité, ou l’efficience. Par ailleurs, vous contestez le relativisme.

EK : Je conteste le relativisme absolu. Mais pas du tout le relativisme… relatif.

AP : Vous vous appuyez sur le fait que certaines théories « fonctionnent » incroyablement bien pour dire qu’on ne peut les mettre en concurrence, dans leur propre champ, avec d’autres formes de représentation. Selon vous, que dit une théorie qui fonctionne, d’une part sur lui-même et d’autre part, sur le réel ? Comment se fait-il qu’un modèle fonctionne s’il ne décrit pas le réel ? De quoi parle la science si elle ne parle pas du réel ?

EK : Les théories qui fonctionnent nous disent quelque chose qui a à voir avec le réel. Mais, dès lors qu’elles se formulent à l’aide d’équations, se pose la question de la part du réel qui est mathématisable….

AP : Dans Science et religion (1935), par opposition à la « vérité absolue » recherchée par la religion et la métaphysique, Russell parle de « vérité technique » pour la science. Elle marche et elle permet des inventions techniques.

EK : Oui, c’est un point très important. Revenons aux critiques des relativistes absolutistes à l’endroit des sciences dites « dures ». Elles visent à démontrer que les activités et les résultats de ces sciences seraient entièrement déterminés par des forces sociales, de sorte que l’ambition de ces sciences à dévoiler des vérités serait infondée. Mais n’y a-t-il pas quelque chose qui cloche dans l’argumentation ? Car contrairement à ce qui se passe avec l’histoire en tant que discipline – où la contestation de l’histoire officielle doit elle-même s’appuyer sur l’histoire, c’est-à-dire sur de nouvelles données historiques – les dénonciations des sciences exactes ne se basent jamais sur des arguments relevant des sciences exactes. Elles s’appuient toujours sur l’idée étonnante qu’une certaine sociologie des sciences serait mieux placée pour dire la vérité des sciences que les sciences ne le sont pour dire la vérité du monde… En somme, il faudrait se convaincre que la vérité n’existe pas, sauf lorsqu’elle sort de la bouche des sociologues des sciences qui disent qu’elle n’existe pas…

Certes, je n’ignore pas que des intérêts militaires ont contribué à l’essor de la physique nucléaire, par exemple. Cela relève d’ailleurs de la plus parfaite évidence : la périphérie de la science et son contexte social influencent son développement. Mais de là à en déduire que de tels intérêts détermineraient, à eux seuls, le contenu même des connaissances scientifiques, il y a un pas qui me semble intellectuellement infranchissable. Car si tel était le cas, on devrait pouvoir montrer que nos connaissances en physique nucléaire exprimeraient, d’une manière ou d’une autre, un intérêt militaire ou géopolitique. Or, vous m’accorderez que si l’humanité décidait un jour de se débarrasser de toutes ses armes nucléaires, il est peu probable que cette décision changerait ipso facto les mécanismes de la fission de l’uranium…

Et si l’atome et la physique quantique n’étaient que de simples constructions sociales, expliquez-moi par quels miracles – oui, je dis bien miracles – on serait parvenu à concevoir des lasers ! Si les lasers existent et fonctionnent, n’est-ce pas l’indice qu’il y a un peu de vrai dans les théories physiques à partir desquelles on a pu les concevoir, de «« vrai »» avec autant de guillemets que vous voudrez et un v aussi minuscule que vous le souhaiterez ?

Le mystère de l’intrication quantique

AP : En physique, Einstein est réaliste, contrairement à Bohr, mais sceptique sur la possibilité de connaître vraiment la réalité.

EK : En effet, et leur opposition a porté sur la bonne façon d’interpréter la physique quantique. Celle-ci repose sur un arsenal mathématique rigoureux et complexe (ce qu’on appelle un « formalisme »), dont le principe fondamental est toutefois simple à énoncer. Nous savons d’expérience qu’il existe plusieurs types d’ondes (acoustiques, électromagnétiques…), et aussi que toutes possèdent une propriété qui leur est commune, indépendamment de la matière de leur support : elles sont capables de s’ajouter entre elles, au sens où la somme de deux ondes d’un certain type est encore une onde du même type. C’est ce principe dit « de superposition », caractéristique du concept d’onde, que la physique quantique a repris pour en généraliser la portée. Voyons comment.

Toute particule se définit par un certain nombre de caractéristiques qui sont identiques pour toutes les particules du même type. C’est ainsi que tous les électrons, où qu’ils soient et dans quelque environnement qu’ils se trouvent, ont rigoureusement la même masse et la même charge électrique. Mais, en plus de ces caractéristiques universelles, les électrons se voient attribuer des quantités qui, elles, peuvent varier de l’un à l’autre, par exemple la position ou la vitesse. L’ensemble de ces quantités forme en physique classique « l’état » de la particule. Comment le représente-t-on en physique quantique ? Réponse : par des entités, notées a, b, c…, dont on exige simplement qu’elles obéissent au principe de superposition. Autrement dit, si a et b sont deux états possibles d’un certain système, alors l’état (a + b) doit être lui aussi un état possible de ce système. Ainsi, le principe de superposition s’applique non plus seulement aux ondes, mais aussi à n’importe quel système physique. La règle de l’addition devient en somme universelle, au sens où l’on fait comme si tout était ondes, alors même qu’expérimentalement ce n’est pas vrai : quand un électron est envoyé sur une plaque couverte d’un produit chimique qui blanchit à son contact, il se manifeste par un impact ponctuel, non comme une onde qui occuperait tout l’espace….

En mathématiques, les entités qui satisfont à cette propriété de pouvoir s’ajouter entre elles sont des « vecteurs » et l’ensemble qu’ils forment constitue un « espace vectoriel ». C’est pourquoi les entités a, b, c représentant les divers états possibles des systèmes physiques sont appelées des « vecteurs d’état ». Ceux-ci sont bien sûr fonctions de l’espace et du temps.

Cette description des états physiques par des vecteurs d’état (ou, si l’on préfère, l’affirmation équivalente que le principe de superposition leur est applicable) est donc l’idée fondamentale de la physique quantique. Il est remarquable qu’un postulat aussi simple, immergé au fin fond d’un formalisme par ailleurs labyrinthique, ait conduit à des progrès aussi considérables dans le domaine de la physique. Grâce à lui, de très nombreux phénomènes incompréhensibles en physique classique ont pu être décrits de façon élégante et synthétique. Par exemple, si la liaison chimique existe, c’est (pour dire les choses rapidement) parce qu’un électron peut être localisé à la fois sur plusieurs atomes, comme « suspendu » entre plusieurs positions, conformément à ce qu’exige le principe de superposition, de même que dans une molécule diatomique, certains électrons, dit de valence, sont à la fois du côté gauche et du côté droit de la molécule, même si cette possibilité semble a priori saugrenue. Par ailleurs, d’innombrables instruments aujourd’hui devenus banals doivent leur existence à la compréhension de cette loi quantique : les transistors, les lasers, les LED…

Tout aussi singulier est le fait que ce sont les conséquences philosophiques du principe de superposition qui ont suscité les difficultés d’interprétation de la physique quantique. On devine leur origine. Le formalisme de la physique quantique opère au sein d’espaces vectoriels abstraits qui sont fort éloignés de l’espace physique où ont lieu les événements que ce formalisme décrit. Cette émancipation vis-à-vis de l’espace physique ordinaire instaure donc une distance entre la représentation des phénomènes et les phénomènes eux-mêmes, distance au sein de laquelle viennent s’engouffrer toutes sortes de questionnements inédits : comment le formalisme quantique se relie-t-il concrètement aux expériences ? Selon quelles règles l’utiliser ? Quels types de discours sur la réalité cette nouvelle physique autorise-t-elle ? C’est par leurs réponses à ces questions qu’Einstein et Bohr se sont opposés, notamment lors de la publication, en 1935, du fameux article EPR.

AP : Est-ce que tout le monde peut le lire ?

EK : Oui, il faut simplement connaître les relations de commutation de Heisenberg, car l’article met en scène une expérience de pensée qui s’appuie sur elle. Considérons, expliquent Einstein et ses deux coauteurs, un système de deux particules identiques, par exemple deux électrons, créées par un processus tel qu’elles partent dans des directions opposées avec des vitesses égales en intensité ; elles sont donc corrélées au sens où la position et la vitesse de l’une d’entre elles sont liées aux grandeurs correspondantes de l’autre particule dans des rapports préétablis ; dès lors, en mesurant la vitesse de la première particule, on peut alors connaître au même instant la vitesse de la seconde (qui vaut l’opposé de celle de la première) sans altérer son état ; la vitesse de la seconde particule est donc un élément de réalité. Si l’on procède de même avec la position, on arrive à la conclusion que la position de la seconde particule est également un élément de réalité. Or, mises ensemble, ces deux assertions contredisent le principe d’indétermination de Heisenberg, selon lequel la position et la vitesse d’une particule ne peuvent pas être déterminées simultanément.

La conclusion des auteurs est simple et directe : la mécanique quantique n’étant pas en mesure de rendre compte de ces éléments de réalité, nous devons considérer qu’elle est incomplète. Ou alors, il faudrait imaginer que la mesure opérée sur la première particule détermine à distance et instantanément, comme par miracle (par « télépathie », dira plus tard Einstein), les grandeurs relatives à la seconde particule, ce qui leur paraît impossible.

La suite de l’histoire va leur donner tort, grâce à une expérience menée au début des années 1980 par Alain Aspect et son équipe. Elle a démontré que, dans certaines situations, deux particules qui ont interagi dans le passé sont « intriquées », c’est-à-dire ont des liens que leur distance mutuelle, aussi grande soit-elle, n’affaiblit pas : ce qui arrive à l’une des deux, où qu’elle soit dans l’univers, est irrémédiablement corrélé à ce qui arrive à l’autre, où qu’elle soit dans l’univers. Comme si l’espace ne jouait plus aucun rôle. C’est ce qu’ils appellent la « non-séparabilité ».

AP : Quelle aurait été la réaction d’Einstein s’il avait pu prendre connaissance de ce résultat ?

EK : Il serait tombé de sa chaise, à supposer qu’il fût assis.

La suite de l’entretien est consultable à cette adresse.